エージェント型AI

DataRobotの違い

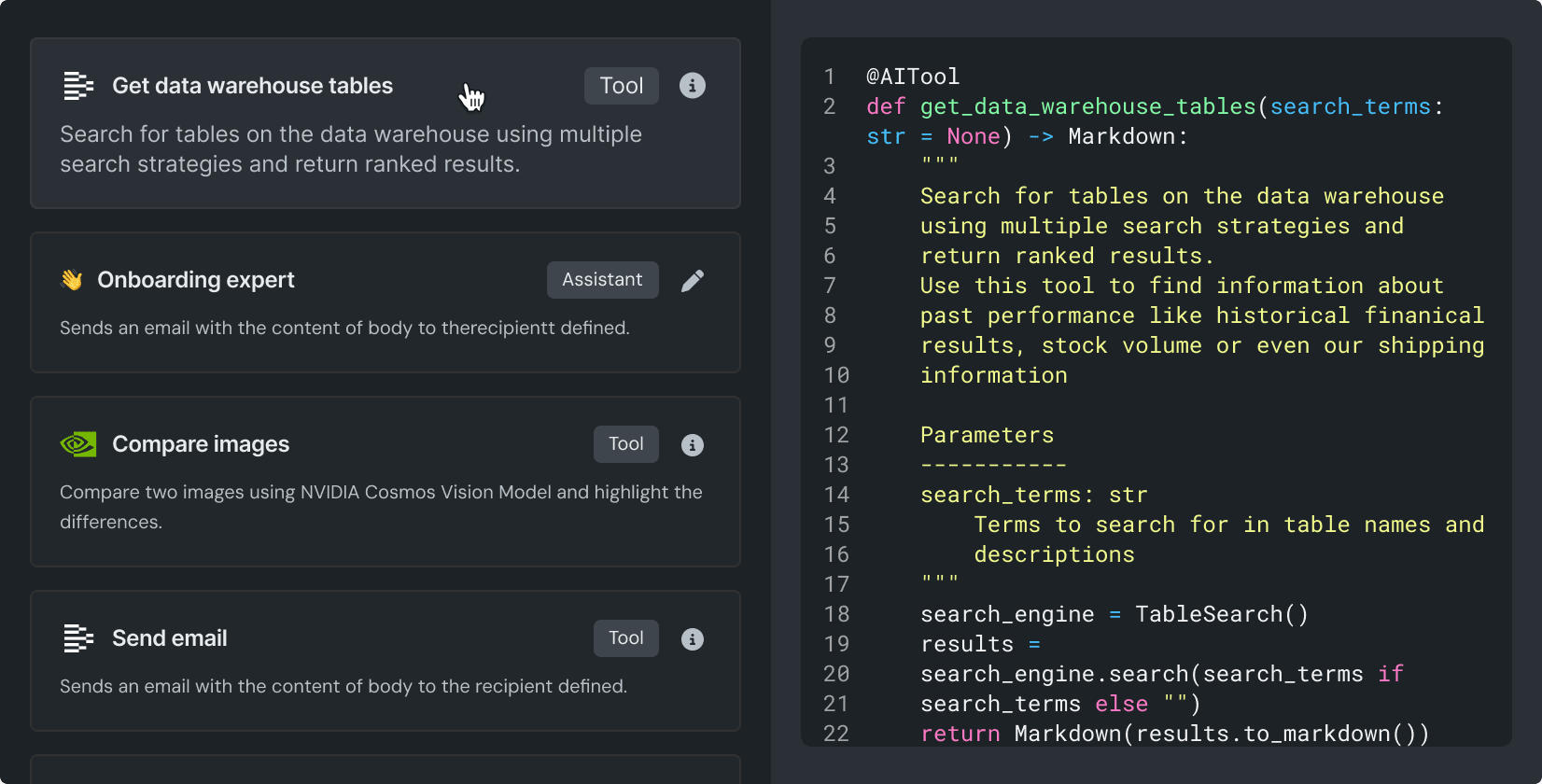

AI ツールの呼び出し: AI ツールおよびコンポーネントをスムーズに呼び出せます。

DataRobot にデプロイされた LLM や AI ツールを、どの開発環境からでも認証を通じて呼び出すことができます。

エージェントにデータセットへのシームレスなアクセスを提供し、必要に応じてデータセットの準備や変換を行います。

すべての AI ツールをチームで使える 単一のリポジトリーに保存することで、バージョン管理やその他の管理作業を容易にします。

ベクターデータベース、埋め込みモデル、および Re-ranker を使用して、RAG ワークフローを強化します。

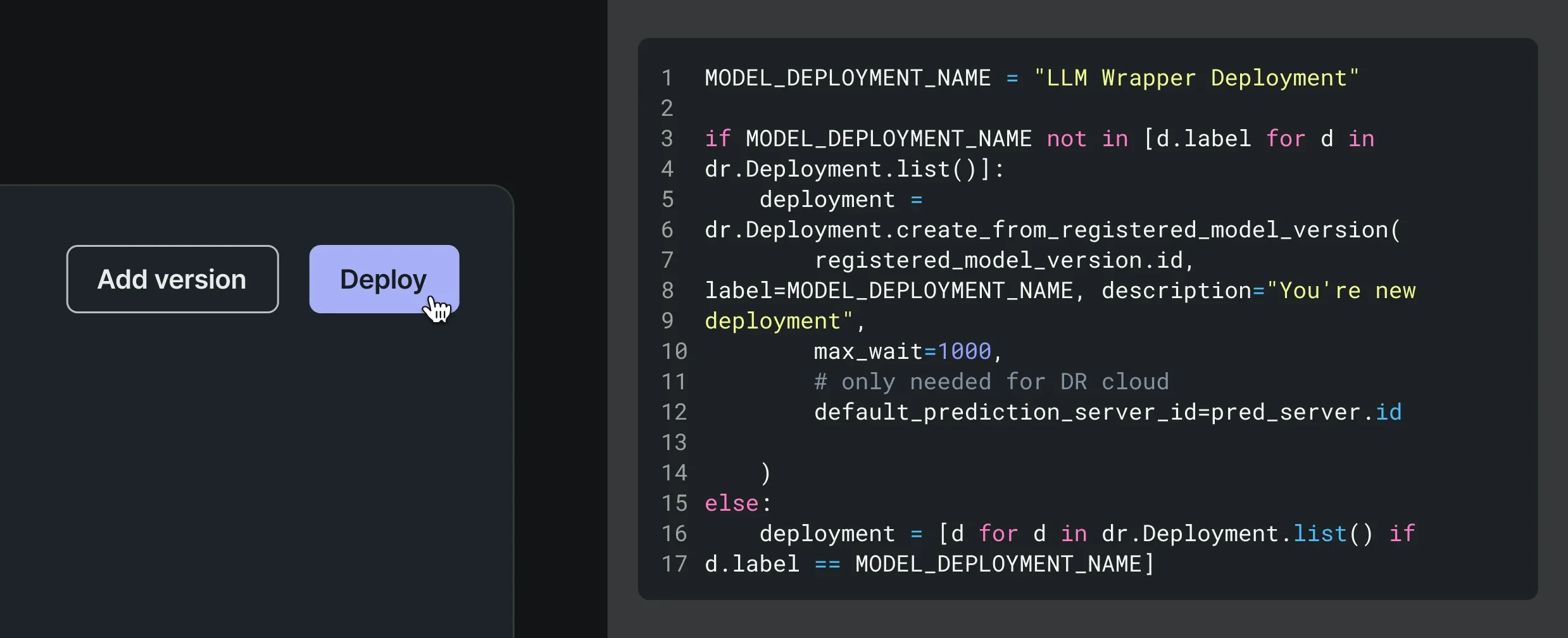

コードファーストのエージェントワークフロー開発ツール: エージェント型 AI のワークフローをあらゆる場所で迅速に構築し、DataRobot 内でのデプロイに向けた準備をシームレスに実行できます。

def load_model(code_dir):

credentials, graph_config = load_config(code_dir)

client = ChatOpenAI(**credentials)

graph = create_react_agent(client, **graph_config)

return graph

def chat(params, graph):

prompt = get_prompt(params)

response = get_response(graph, prompt)

return format_chat_completion(response, params)CrewAi、Langchain、Llamaindex の組み込み済みテンプレートと、あらゆるフレームワークに対応した汎用テンプレートを使用して、エージェントワークフローのプロトタイピングを加速できます。

すぐに使える CLI を使って、ローカル環境からシームレスにコードを取り込み、本番環境用のエージェントワークフローを準備できます。

細部レベルでのエラー検出により品質を確保し、コードの即時再実行で素早くデバッグできます。

LLMによる評価(LLM-as-a-Judge)や柔軟なプレイグラウンド環境で、複数のワークフローを並べて評価、比較できます。

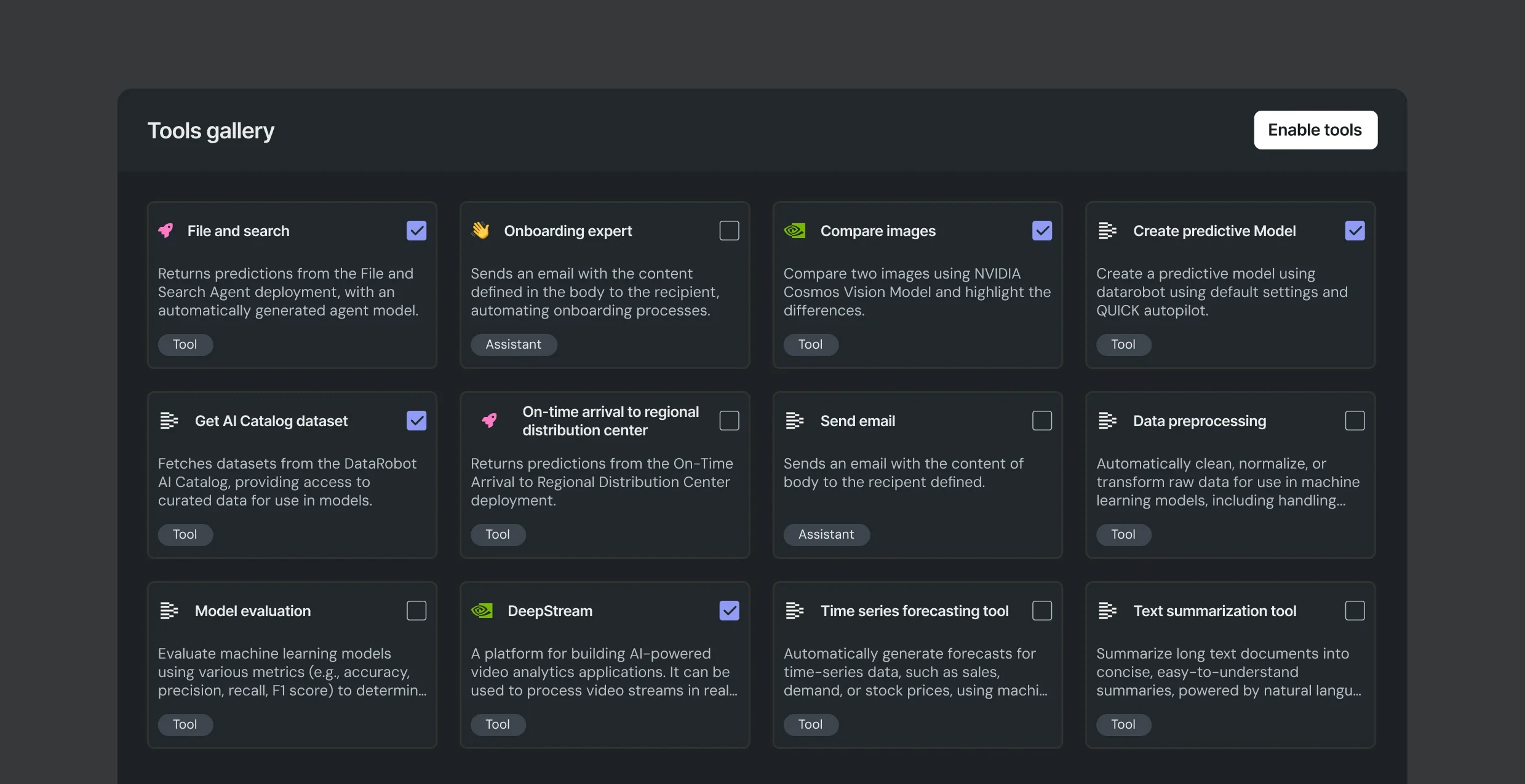

AI ツール構築プラットフォーム: エンドツーエンドの実験および開発ツールを利用して、エージェント型アプリ向けにカスタマイズされた AI ツール群を構築できます。

複数の LLM を並べて比較し、ベクターデータベースと埋め込みモデルをテストし、グラウンドトゥルースとコンプライアンスのテストを効率化できます。

数百の予測モデルを迅速にテストし、自社のユースケースにおいて最も重要なパフォーマンス指標に基づいて調整できます。

整理されていない未加工のデータを、構造化されたクリーンなトレーニングデータセットや、すぐに使える表形式のデータセットに変換できます。

チャンキング戦略、埋め込み手法、コンテキスト認識機能、インデックス作成手法を活用し、ユースケースに合わせて高速かつコンテキストを認識するベクトルデータベースを構築します。

事前構築済みのエージェント型 AI ツールのライブラリー: 1 行のコードで構築、カスタマイズ、デプロイが可能な AI ツールを使用して、エージェント型アプリケーションを強化できます。

データを活用する意思決定者が、データソース、テーブル、データウェアハウスをまたいでセルフサービスでデータのクエリーと分析を実行できるよう支援します。

時系列予測をエージェント型 AI アプリに組み込み、サマリーを自動生成します。

エージェントが、出力や予測の結果をもとに、実用的なメールやパーソナライズされた顧客向けコンテンツを作成できるようにします。

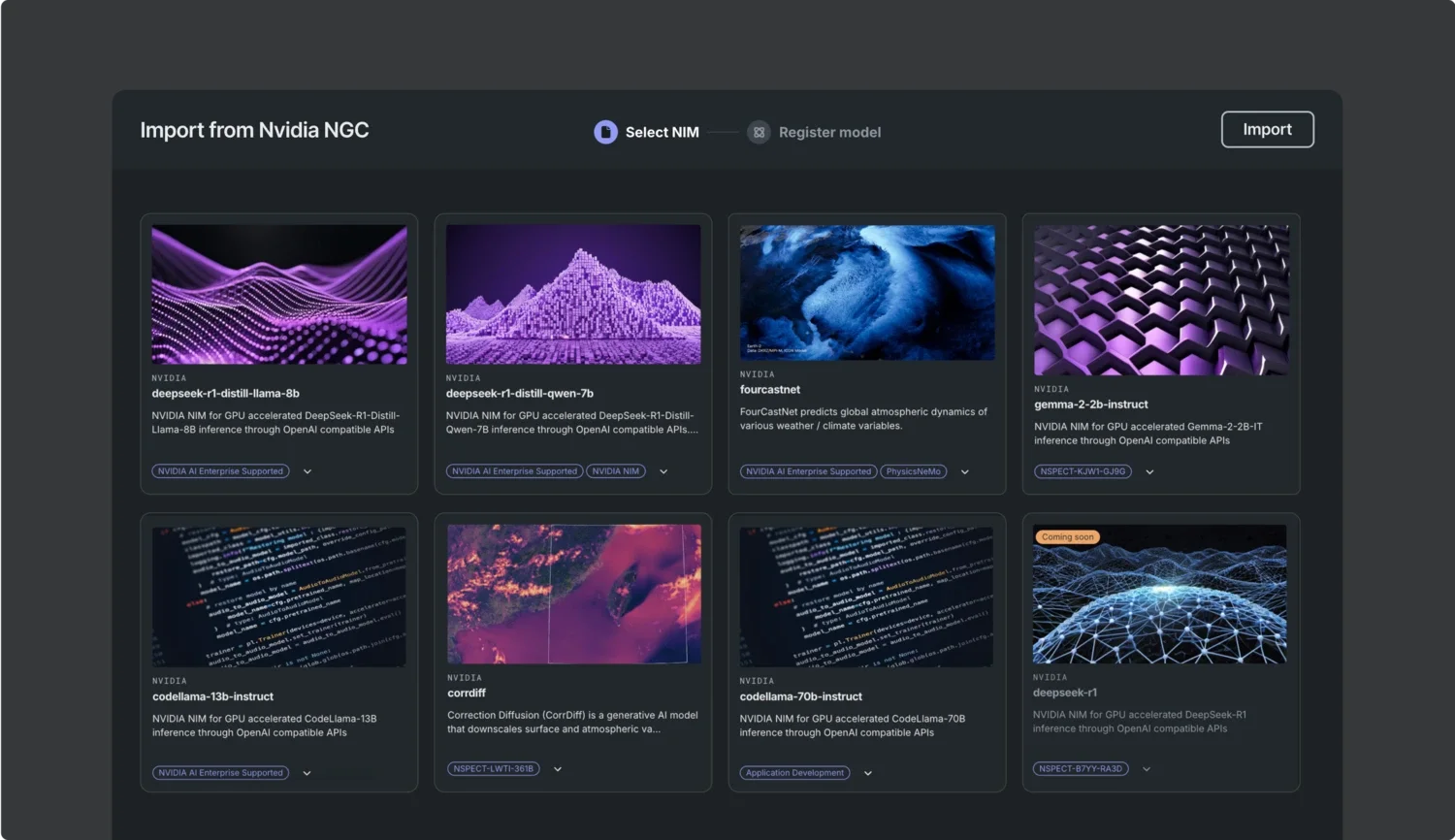

NVIDIA NIM および NVIDIA NeMo マイクロサービスのライブラリーへのネイティブアクセス: 事前構築済みの AI コンポーネントを使用して、AIエージェントアプリケーションを強化できます。これらのコンポーネントは、テキスト、画像、PDF の処理に対応し、エンタープライズ対応のガバナンスとオブザーバビリティを備えており、組み込みもわずか数分で行えます。

テキスト、画像、PDF 文書といったマルチモーダルデータソースから取り込みを行い、インサイトを引き出します。

ライブビデオや録画済みのビデオを、対話型 AI アプリケーションで使用できる構造化されたサマリーに変換します。

プロンプトを最適なモデルにインテリジェントに振り向けることで、推論の深さと計算効率のバランスを最適化します。

マルチモーダル AI エージェントを構築して、高品質な研究レポートを数分で生成できます。

NVIDIA GPU および NVIDIA AI Enterprise 製品を簡単に活用: インフラストラクチャに関する高度な知識がなくても、任意のクラウド、オンプレミス、ハイブリッドクラウドで NVIDIA GPU を実行することで、コスト、レイテンシー、可用性を最適化できます。複雑な設定、チューニング、トラブルシューティングは必要ありません。

prediction_environment = datarobot.PredictionEnvironment(

resource_name="my serverless environment",

platform="datarobotServerless",

)

TEXTGEN_REGISTERED_MODEL_ID = "your-model-id-here"

# Retrieve registered model

registered_model = datarobot.RegisteredModel.get(

resource_name="Registered NIM Model",

id=TEXTGEN_REGISTERED_MODEL_ID,

)

# Create the deployment

deployment = datarobot.Deployment(

resource_name="NIM - Llama 3.3 70B",

registered_model_version_id=registered_model.version_id,

prediction_environment_id=prediction_environment.id,

label="NIM - Llama 3.3 70B",

use_case_ids=[use_case.id],

)NVIDIA GPU を使用して任意のクラウド、オンプレミス、ハイブリッド環境にデプロイすることで、レイテンシーとコストを最適化できます。

NVIDIA のリソースおよび NVIDIA AI Enterprise を使用すれば、事前構築済みのエージェントワークフローを最小限の設定作業でデプロイできます。

NIM でコンテナと NVIDIA GPU を自動的に管理することで、デプロイにかかる手間を軽減します。

NVIDIA NeMo Guardrails を完全に統合して、モデルを不正使用や脅威から保護し、安全なデプロイを実現します。

ワンクリックデプロイ: エージェント型アプリケーションを、外部チームに頼ることなく一貫した品質で迅速にデプロイできます。パイプラインの中断や部門を越えた支援を必要とせずに、AI ツールの迅速な置き換えや更新をシームレスに行えるため、実験の範囲とスピードを最大化できます。

フルマネージドのインフラストラクチャ: リソースの管理ではなく、効果的なエージェント型アプリケーションの構築に専念できます。

インフラストラクチャーの管理、プロビジョニング、スケーリングを自身で行うことなく、AI を開発できます。

自動化され、本番環境に対応したパイプラインにより、予測モデルと生成モデルを常に最新の状態に保ちます。

強力な生成 AI リソースにオンデマンドでアクセスし、必要に応じてプラットフォーム内で GPU を直接購入できます。

教師あり学習のあらゆるユースケースにおいて、簡単な API 呼び出しで予測を生成できます。

ボルトオンのガバナンス: わずか数行のコードで、どこで構築された AI アプリでもDataRobot が追跡し、管理できます。

base_url = "https://app.datarobot.com/api/v2/deployments/6733dfefc06c302cfa/"

api_key = os.getenv("DATAROBOT_API_KEY")

model_name = "datarobot-deployed-llm"

client = OpenAI(base_url=base_url, api_key=api_key)

completion = client.chat.completions.create(

model=f"{model_name}",

messages=[

{"role": "system", "content": "you are a helpful assistant."},

{"role": "user", "content": "where is Datarobot HQ'ed"},

],

)AI エージェントと AI ツールのガバナンス: すべての AI ツールおよびコンポーネントの安全性、セキュリティ、コンプライアンスを確保します。

事前構築済みのガードモデルのライブラリーを使用して、誤用、脅威、ハルシネーションをリアルタイムで検出し、軽減します。

LLM をテストし、監査に対応したレポートを生成できます。手動でのレポート作成は不要です。

AI の応答とベクターデータベースとの整合性を追跡し、問題を特定して精度を向上させます。

カスタム承認エージェントのワークフローを構築することで、チームの意思決定を管理して円滑な運用を維持できます。

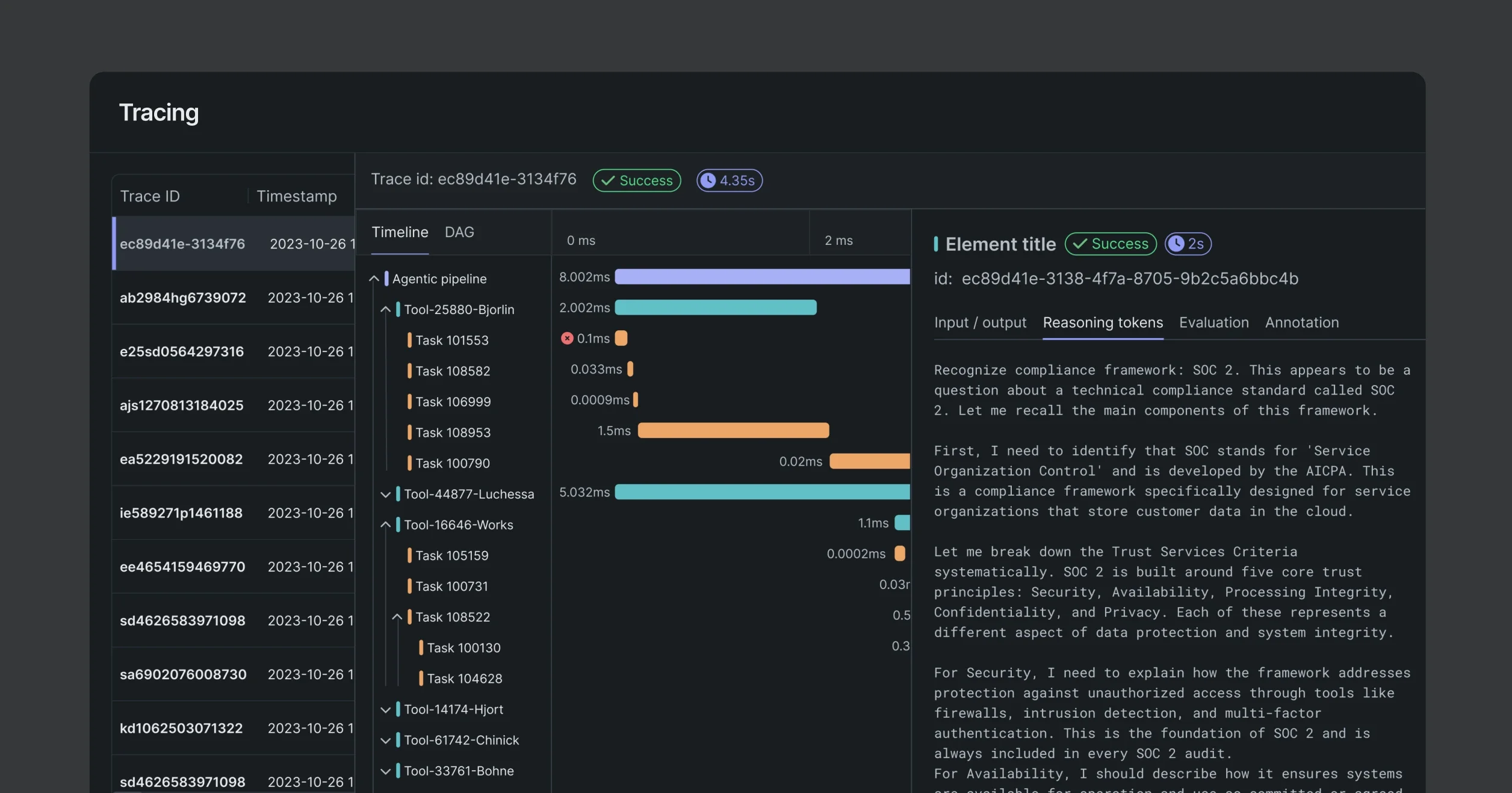

エンドツーエンドでエージェントとツールを監視: 本番環境のすべてのエージェントとツールを、ビジネス目標に合わせた詳細な指標で監視します。

独自の監視指標を定義して、GPU コストや PII リスクなど、最も重要な項目を追跡します。

すべての出力結果を入力、使用ツール、意思決定にまでさかのぼってトレースし、完全な監査性を確保しながら、オープンテレメトリーとの互換性を維持します。

本番環境におけるパフォーマンスの低下を監視し、テキストや位置情報に基づくデータドリフトを特定します。

詳細な正常性レポートを自動生成し、関係者やコンプライアンスの要件に対応できるようにします。