生成 AI

事前構築済みの生成 AI アプリケーションおよびコンポーネントを使用して開発を迅速化: 事前構築済みの生成 AI アプリケーションには、本番環境での実行に必要なカスタマイズできるコンポーネントがすべて揃っています。このアプリケーションを活用することで、従来の何倍ものユースケースをテスト、イテレーション、および展開できます。

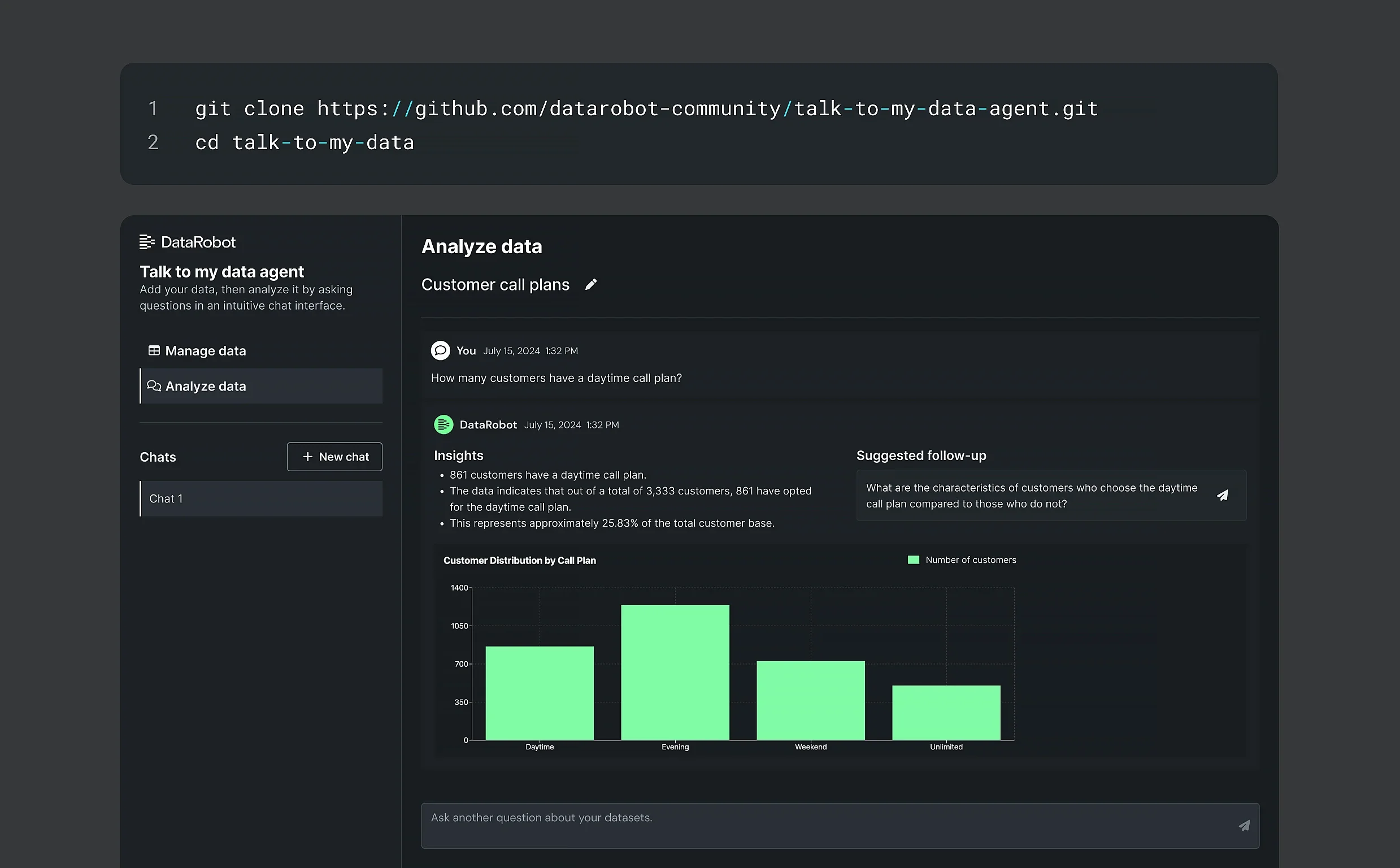

データを活用する意思決定者が、会社の表形式データや文書に関する重要なインサイトを安全に収集できるよう支援します。

顧客に関するデータと予測に基づきコンテンツを継続的に生成することで、事業の成長を促進します。

時系列予測を生成 AI によるサマリーや予測の説明で補完して、予測分析をより理解しやすくします。

GUI およびコードベースの生成 AI ツールで複数のエコシステムにわたる開発を実現。 あらゆる LLM、SLM、ベクターデータベース、埋め込みモデルの開発、検証、デプロイを迅速に行えます。また、認証情報はすべて DataRobot が管理します。

API キーの取得やアカウント管理に煩わされることなく、70 以上の生成 AI モデルや埋め込みモデルを柔軟に組み合わせて利用できます。

大規模なワークロードを複数のクラウドリソースに分散して実行することで、生成 AI ワークフローのレイテンシー、コスト、可用性を最適化します。

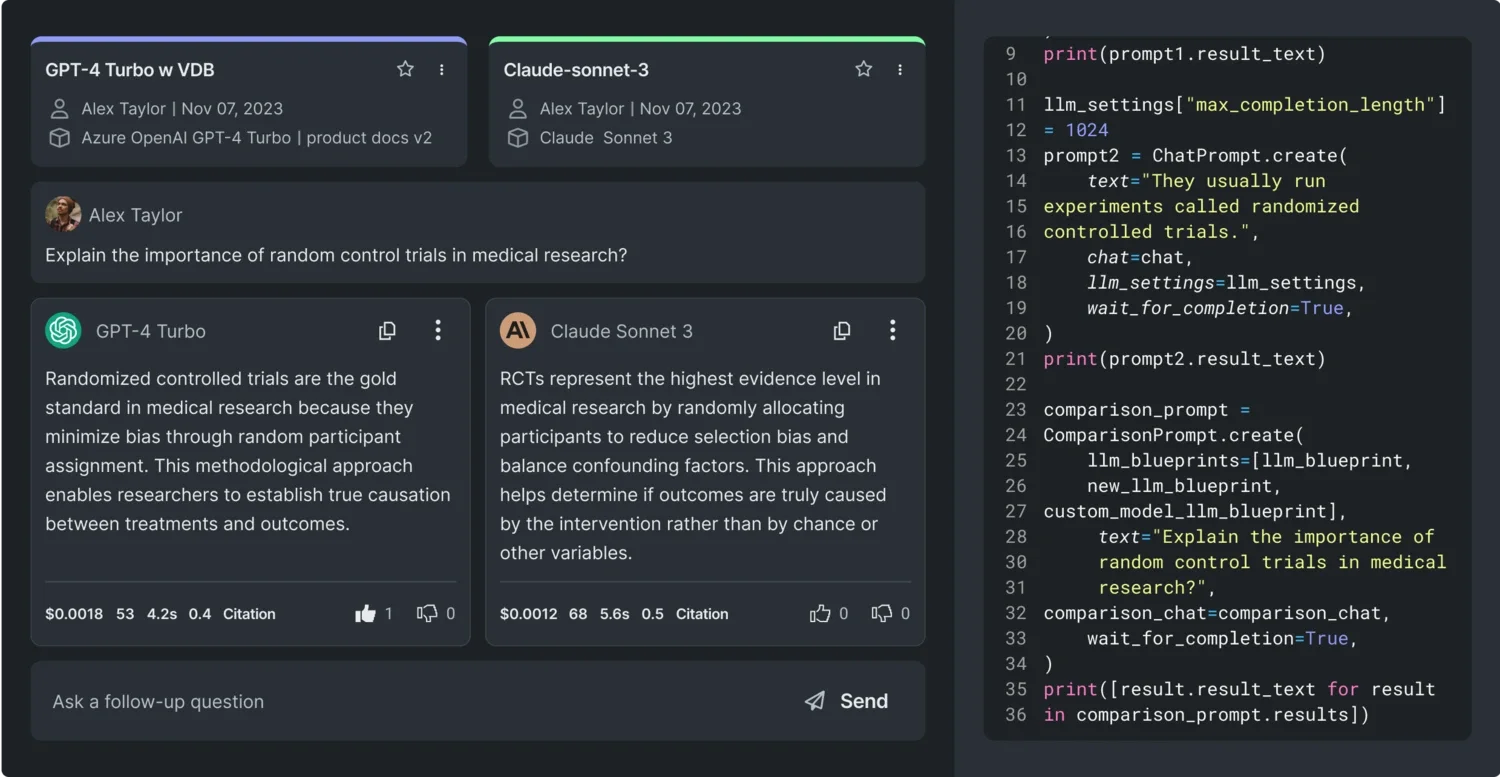

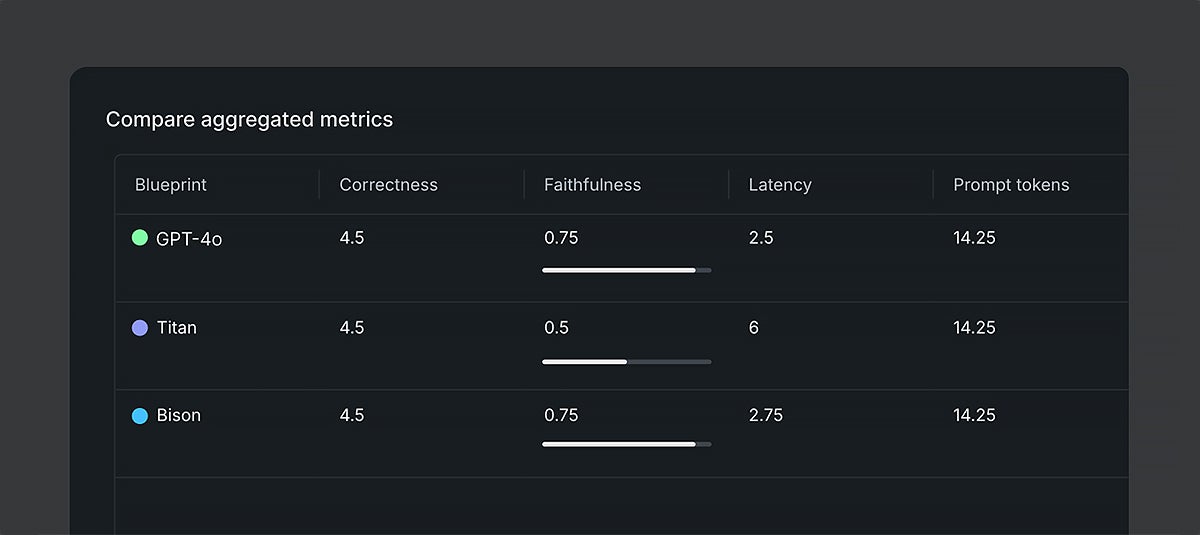

プロンプトのテスト、設定の微調整、出力結果の比較を実施し、パフォーマンスが最も高い構成を特定します。設定を選択し、さまざまなプロンプトを使ってすばやく実験することで、どのモデルが最も優れた出力を生成するかを検証できます。

LLM のベクターデータベース、Retriever、プロンプトを単一のエンドポイントに統合し、どこからでも呼び出せるようにします。

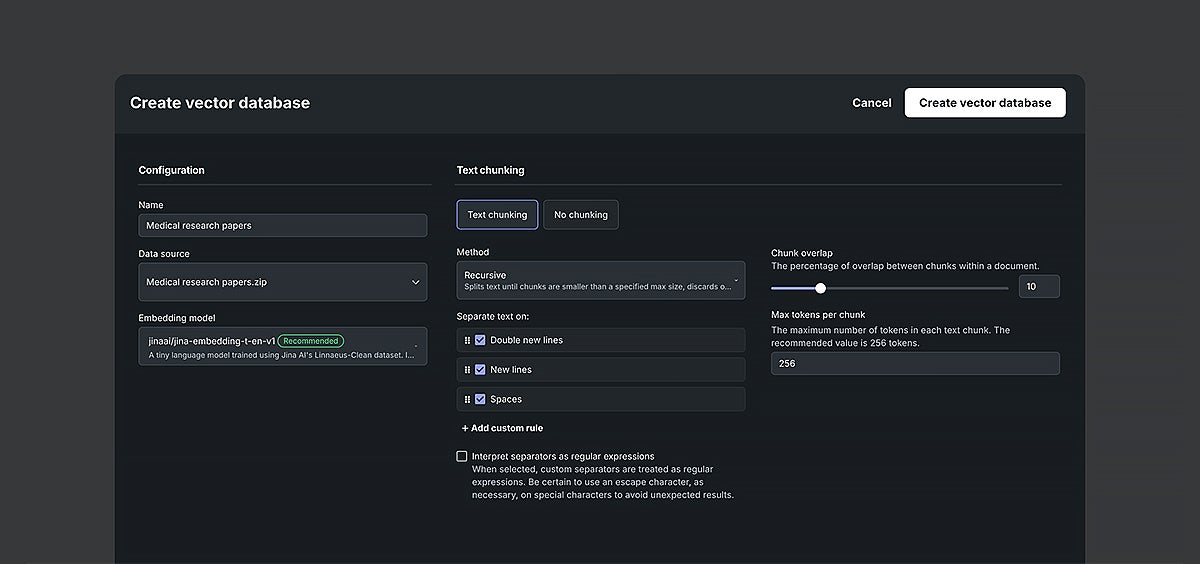

先進的な RAG システムを構築: Pinecone や Elasticsearch など外部のベクターデータベースを独自に導入するか、さまざまなチャンク化戦略やコンテキスト特徴量を使ってすばやく実験しながら独自のモデルを開発することで、生成 AI のワークフローに RAG をシームレスに組み込むことができます。

チャンクサイズの変更や、テキストを意味に基づいてフレーズ単位で分割する作業をシームレスに行うことで、迅速な探索を実現します。

メタデータを活用してベクトルをインデックス化するため、検索の速度と全体的な精度が向上します。

チャット履歴に基づいてプロンプトの書き換えやクエリーの分割を行い、文脈理解を強化します。

オンデマンドの GPU を使用して独自の埋め込みモデルをホストするか、DataRobot を使って埋め込みを生成できます。

ワークフローのパフォーマンスをシームレスに評価: エコシステムの専用の LLM やグラウンドトゥルースのデータセットを使用して、モデルのベンチマーキングと比較を迅速に実施できます。

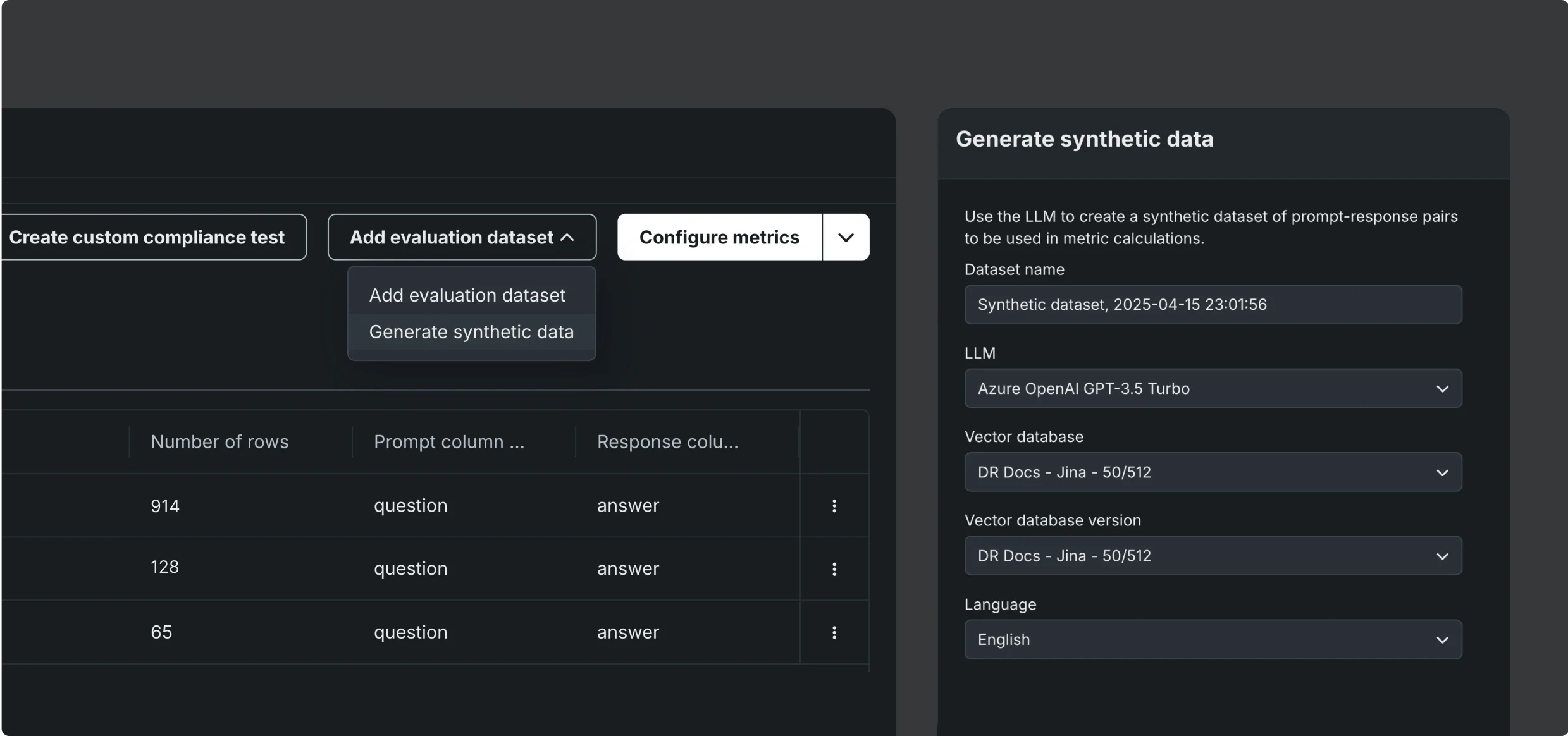

大量の質問と回答のペアの合成データを高速で生成: 既存のベクターデータベース全体を対象として、ニーズに合わせて完全にカスタマイズ可能なグラウンドトゥルースのデータセットを自動で構築することで、生成 AI ワークフローの評価を即座に開始できます。

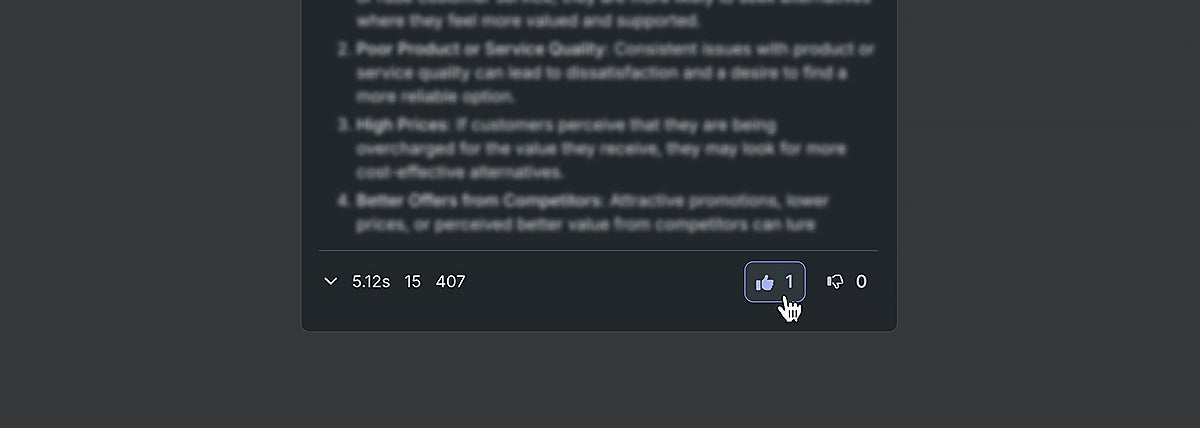

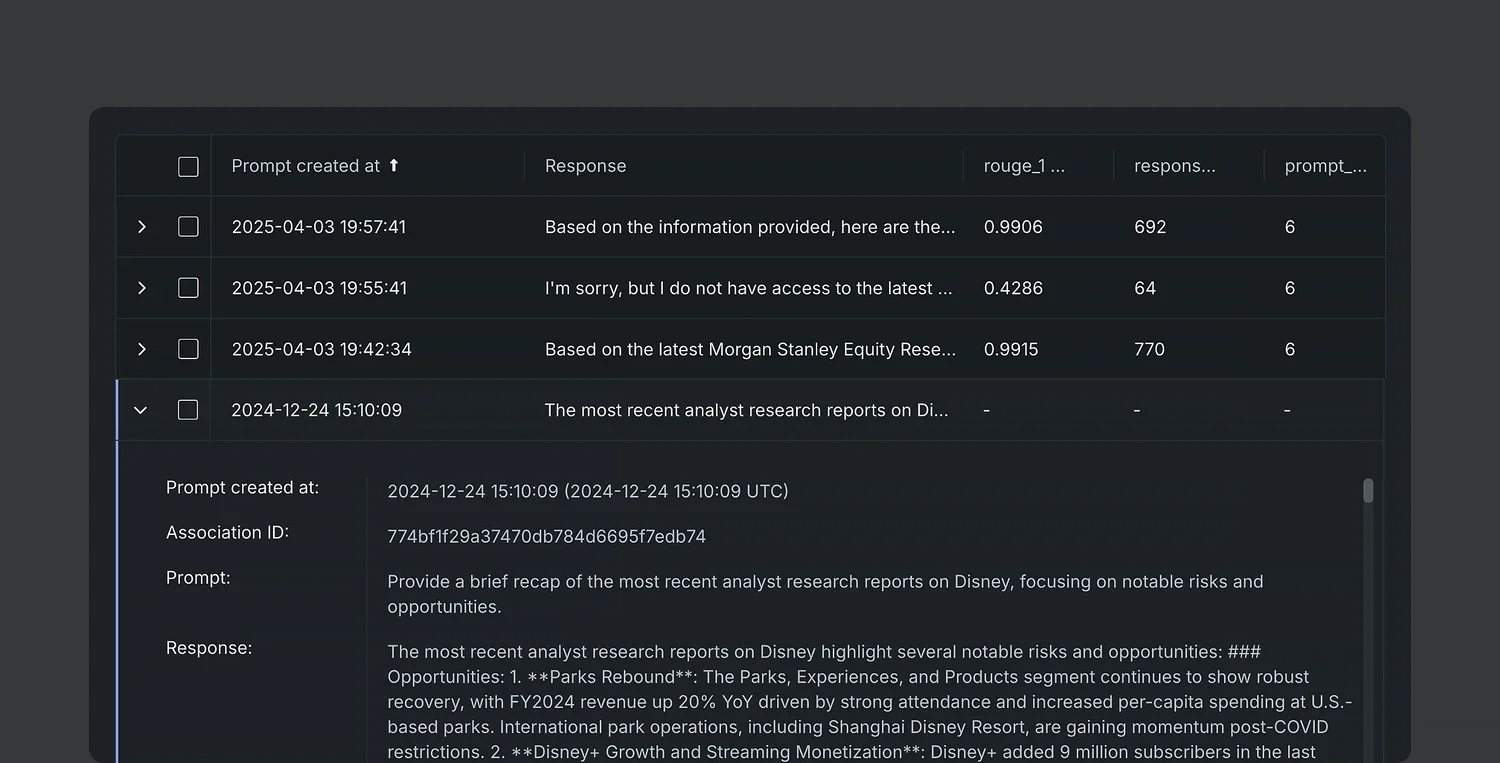

関係者によるリアルタイムのフィードバックを促進: アプリの出力結果に関する人間のフィードバックを自動で収集し、応答を細かくチューニングすることで、ユーザーのニーズに合った生成 AI モデルを実現します。評価基準は、ユースケースで重視される観点に合わせてカスタマイズできます。

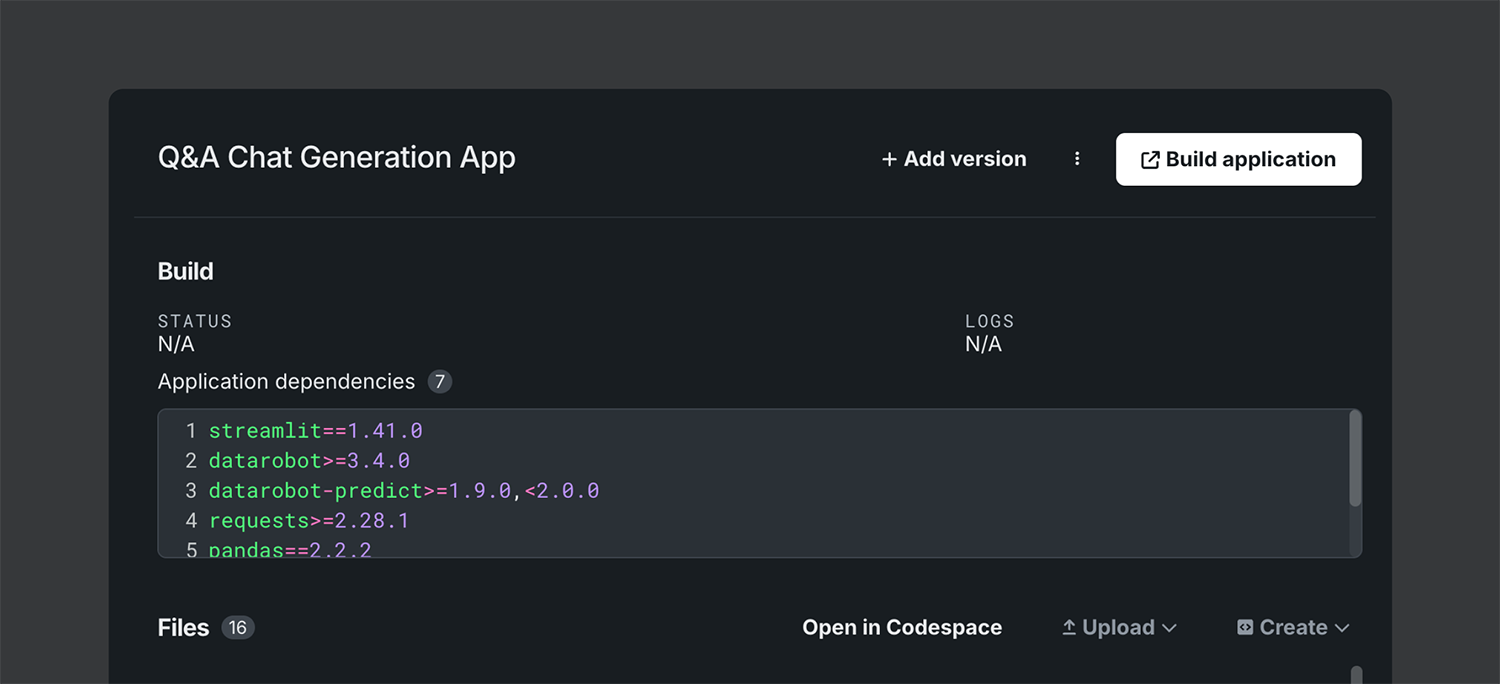

Q&A エクスペリエンスを通じてモデルの迅速な導入を促進: ワンクリックで、主要な関係者に URL で共有できる洗練された Q&A プロトタイプアプリを作成したり、チームからフィードバックを収集したりできます。

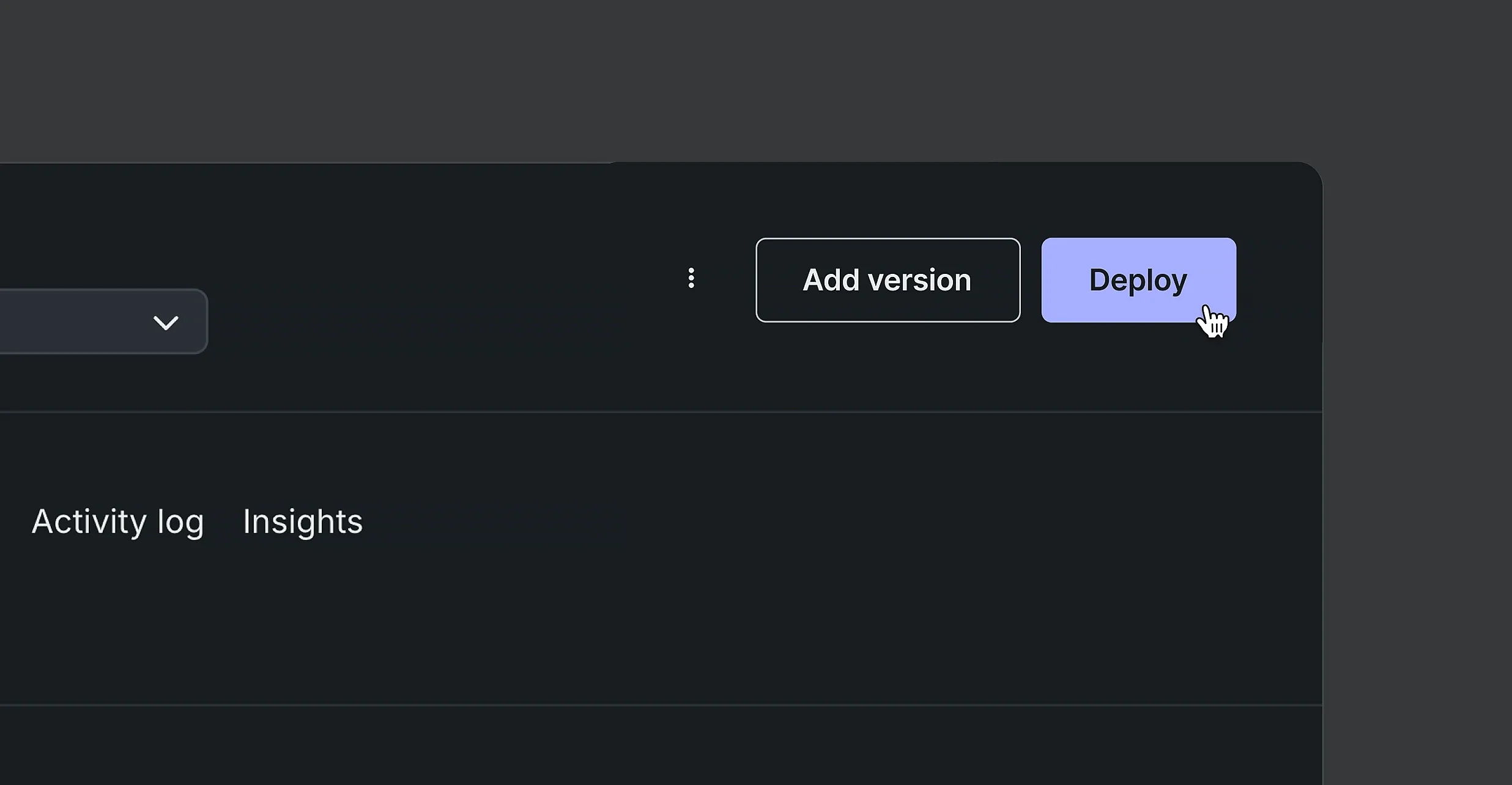

非常に簡単なデプロイ: NVIDIA NIM 向けに自動で管理および設定される Infrastructure as Code ワークフローや宣言型 API、GUI ボタンを使用して、生成 AI を迅速に展開できます。新しいバージョンへの切り替えも、パイプラインや本番ワークフローを中断することなくスムーズに行えます。

ビジネスに AI アプリを融合させる: 生成 AI アプリケーションを既存のチャットアプリケーションとシームレスに統合し、ビジネス関係者がすでに使用している環境に対応します。

使い慣れた開発ツールを使用してアプリの UI をゼロから構築: 複雑な開発環境の設定をすることなく、使い慣れた Python の可視化フレームワークを利用できます。

生成 AI ワークフローのあらゆるノードを追跡することで品質を保証: すぐに使える LLM の履歴に含まれるすべてのプロンプトとベクトル入力に基づいて、問題のデバッグや、ワークフローの思考プロセスと出力結果の追跡を迅速に行えます。

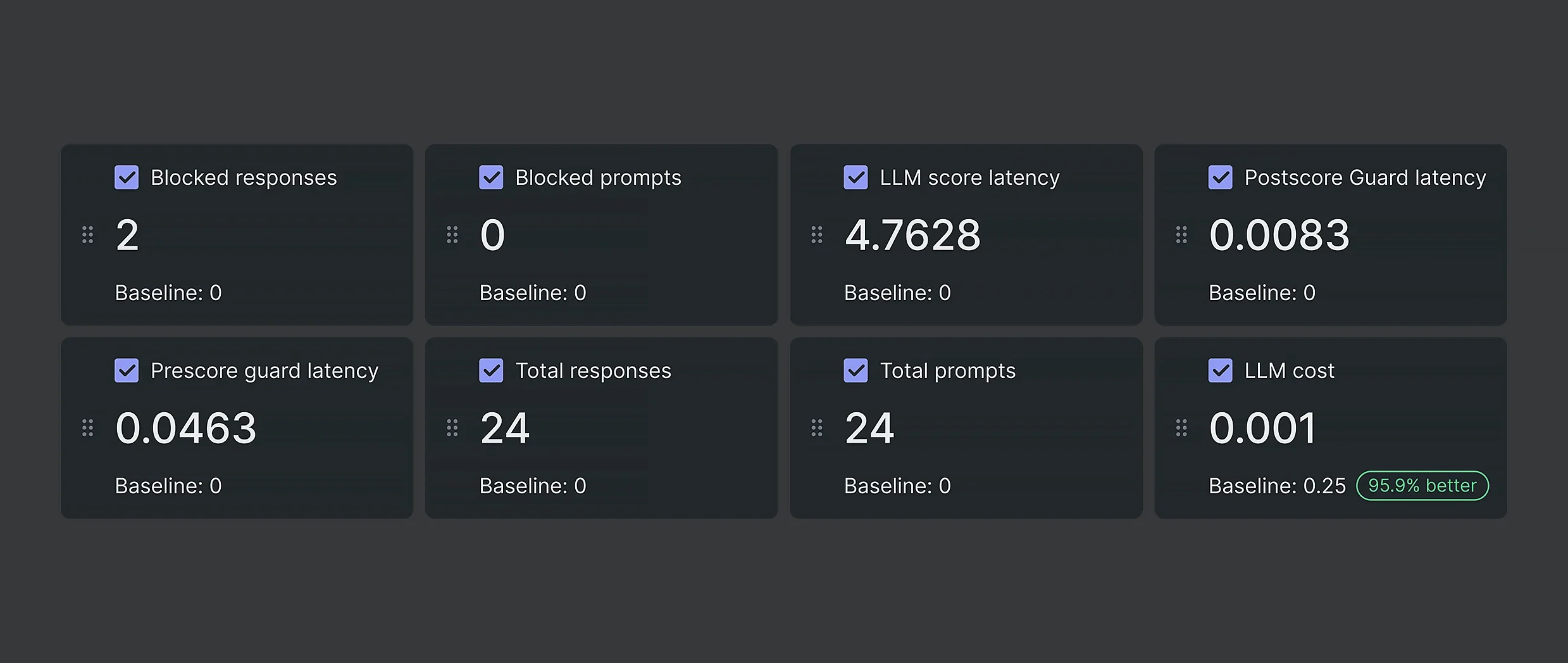

問題の検出時に自動で介入: LLM ガードをライブラリーから選択するか独自のものを組み込んで、安全性、品質、コストに関するリスクを継続的に監視し、有害な出力をリアルタイムで防止します。

専用の LLM-as-a-Judge をはじめとする多様なガードレールを備えたライブラリーによって、品質を確保してハルシネーションを防止します。

NVIDIA のギャラリーから NVIDIA NeMo Guardrails を選択して登録し、オンプレミスまたはクラウドに導入できます。

プロンプトおよび応答のトークンを追跡し、本番運用のコストを算出し、その最小化を支援します。

応答の監視や介入の自動化によって、プロンプトインジェクションや PII リーケージなどの不正利用を防ぎます。

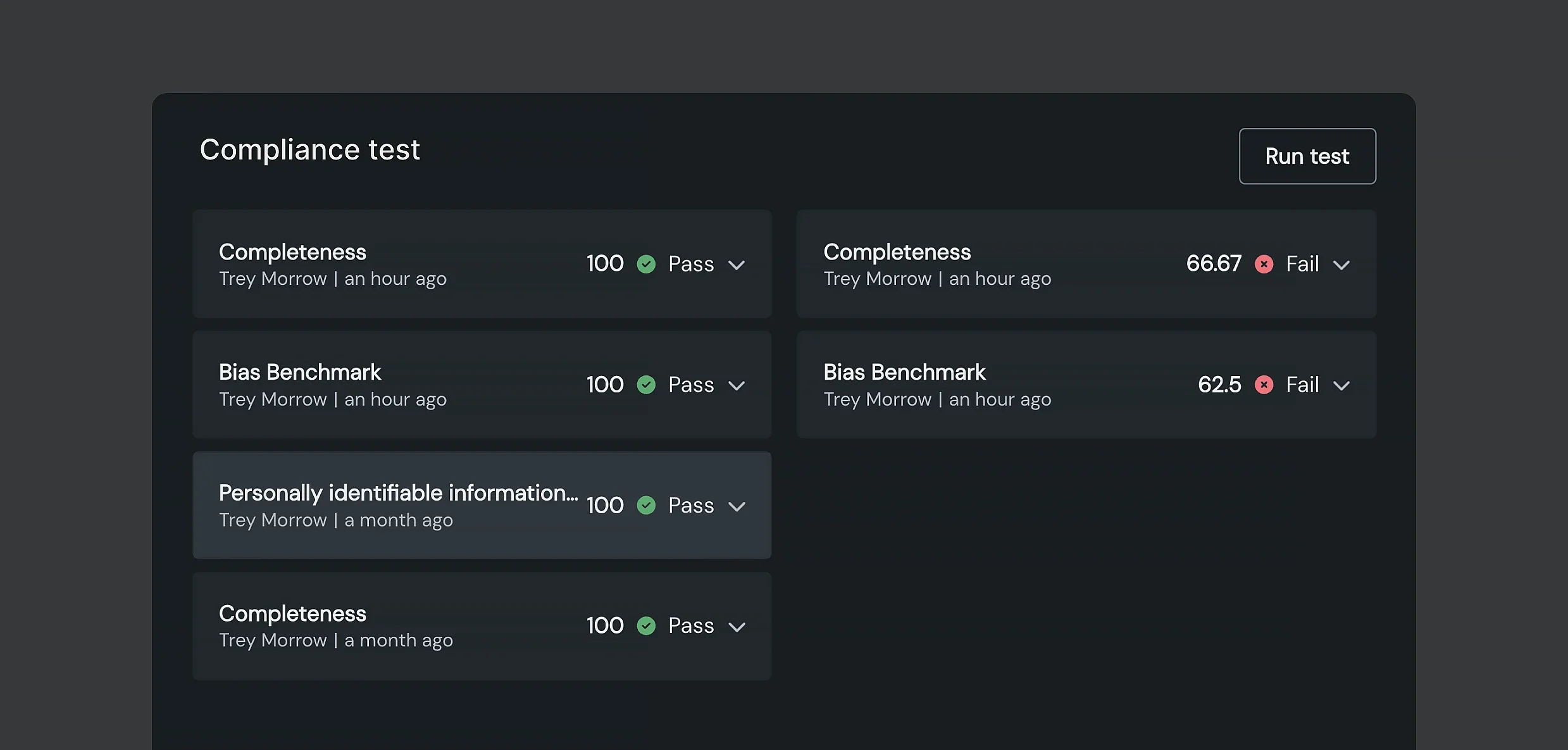

コンプライアンスの自動チェックで規制リスクを軽減: 事前構築済みのコンプライアンスチェックを利用するか、第三者のデータを使用して組織の要件に合わせたカスタムテストを作成し、変化する規制に先手を打って対応します。

すべてのワークフローにおいて、特定済みのリスクが確実に考慮され、規制要件を満たすために必要な文書化が行われるようにします。

ワークフローが EU AI 法、NIST RMF、ニューヨーク市法第 144 号、コロラド州法 SB21-169、カリフォルニア州法 AB-2013、SB-1047 などの各規制に準拠し、安全に利用できるものであることを保証します。

完全性、PII 検出、有害性、バイアス、ジェイルブレイクの試行に関するテストを、クリック操作で簡単に実行できます。組織固有の内部または外部の要件に基づき、カスタムテストを作成できます。

コンプライアンスドキュメントの自動作成: 手作業を減らし、コンプライアンスに対応したドキュメントをワンクリックで作成できます。

最も重要な指標を追跡: モデルを本番環境で継続的に監視するための、すぐに使える指標が用意されています。これらの指標はニーズに合わせてカスタマイズも可能です。