説明可能性は信頼できる AI に欠かせない要素

説明可能性は、ユーザーとモデルの間に信頼を築くうえで最も直感的で強力な方法の 1 つです。モデルの実用化を論証する場合でも、AI システムの個々の推奨事項を理論的に解明する場合でも、モデルがどのように動作して決定を下すのかを理解できれば、最終評価に向けて大いに役立ちます。

モデルの “説明可能性” とは

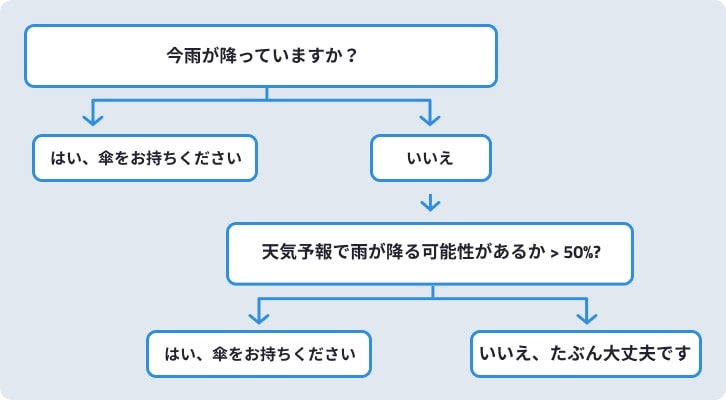

係数が各変数に割り当てられているシンプルな線形回帰モデルは、極めて直接的に解釈できます。同様に、図 1 に示すようなシンプルな決定木は、それを見るだけで直感的に理解できます。完全な透明性がある、つまり、設計を構成するすべてのパラメーターを操作できるこれらのモデルは、まさに説明可能であると言えます。

シンプルな決定木の例では、「今日外出するときに傘を持って行くべきだろうか」という質問に答えていますが、これを 1 つの二値変数(“今雨が降っているか”)および 1 つの数値変数(天気予報の降水確率)を評価して推奨事項を出力するモデルと考えることができます。ここには、さらに高度なツリーベースのアルゴリズムを構築する際の基盤となるメカニズムが反映されています。このベースライン程度の複雑さで透明性が保たれていれば、人間の認知力にとって完全に説明可能であり、追加の支援やインサイトは必要ありません。

しかし、ほとんどの機械学習モデルは、さらに複雑なアルゴリズムを基盤としています。たとえば、ランダムフォレストモデルは、実際には何十もの決定木の集合体です。複雑さがそこまで増大すると、モデルの透明性と説明可能性の関連がなくなってきます。専門のデータサイエンティストであっても、ニューラルネットワークの各ノードに割り当てられた重み付けが開示されれば、それだけモデルを容易に解釈できるようになるわけではないのです。これは、この種の複雑なモデルを説明したり、その決定を理解したりすることが不可能であることを意味するものではありません。説明可能な AI を実現するには、異なるツールセットを適用する必要があるのです。

説明可能なモデルを作成する方法

モデルの説明可能性を実現するために利用できるインサイトには多くの種類があります。

- 特徴量の有用性に関する各手法はモデルの全体的な意思決定のレベルで機能し、各特徴量の予測力を集約してスコアリングします。

- 部分依存グラフを使えば、特定の特徴量がモデルの予測にどのように影響するかを、特徴量が取り得る値の範囲全体を通して把握できます。

- 予測の説明では、1 つの予測結果において最もインパクトの強かった要素を個々に特定できます。DataRobot では、要素のインパクトを計算する 2 つの代表的な方法、XEMP と SHAP をサポートしています。

説明可能性はパズルの 1 ピースにすぎません

説明可能性は、信頼できる AI の倫理面において必要な要素の 1 つにすぎません。その他の要素には次のようなものがあります。